Удаленное управление узлами hyper-v с помощью диспетчера hyper-v

Содержание:

- Введение

- Основные сведения о виртуализации процессоров Hyper-V

- Настройка виртуальных коммутаторов

- Основы работы с сетями Hyper-V

- Изменение параметров виртуальной машины.

- Принцип работы вложенной виртуализации

- Настройка сети и Интернета для виртуальной машины

- Выбор оборудования

- Предварительные требования

- Как работает Hyper-V на VDS

- Максимум для виртуальных машин

- Какие гостевые операционные системы поддерживаются?

- поддержка Windows гостевой операционной системы

- поддержка гостевых операционных систем CentOS и Red Hat Enterprise Linux

- Поддержка гостевой операционной системы Debian

- Поддержка гостевой операционной системы FreeBSD

- Поддержка Oracle Linux гостевой операционной системы

- Поддержка гостевой операционной системы SUSE

- Поддержка гостевой операционной системы Ubuntu

- How to Download, Install, and Access Hyper-V Manager

- Рекомендации по схеме управления питанием

Введение

Ранее я рассказывал об установке и настройке Hyper-V Server 2012 R2, предыдущей версии бесплатного гипервизора. К сожалению, те методы настройки hyper-v в рабочей группе без домена неактуальны в версии 2016. В частности, утилита hvremote не работает на новой версии. Изменились настройки машины для управления. В данном случае в ее качестве будет выступать рабочая станция под управлением Windows 10.

Но в общем и целом мне нравится гипервизор hyper-v, поэтому я решил внимательно проработать вопрос установки и первоначальной настройки для дальнейшего использования по мере необходимости. К плюсам hyper-v в целом и бесплатной версии в частности я отношу следующие моменты:

- Поддержка всех популярных ОС. Нет никаких проблем с совместимостью, нет необходимости отдельно ставить какие-то драйвера или тулсы. Поддержка hyper-v присутствует во всех windows системах, в ядре линукс, не помню точно с какой версии, но все современные системы ее имеют, в ядре freebsd, начиная с 10-й версии. То есть вы просто берете установочный диск и ставите систему на hyper-v, больше от вас ничего не требуется.

- Много различных способов бэкапа виртуальных машин. Это могут быть простые скрипты, бесплатные программы, либо полноценные платные версии крупных компаний, специализирующихся на программном обеспечении для бэкапа.

- Стандартная панель управления гипервизором, которую легко установить на компьютер под управлением windows, начиная с win 8.1.

- В основе Hyper-V Server популярная серверная система, с которой понятно и удобно работать. К примеру, чтобы загрузить или забрать файл с гипервизора, вам достаточно расшарить на нем папку стандартным образом, как вы это делаете в любой windows системе.

Это мое личное мнение, основанное на опыте работы с малыми и средними компаниями, где нет каких-то особенных требований к надежности и доступности сервисов. Где используются несколько серверов с виртуальными машинами, не всегда есть домен windows. Конечно, помимо плюсов, есть и минусы. Первый и главный для меня минус — первоначальная настройка. Нельзя просто взять, установить Hyper-V Server и начать им пользоваться. Необходимо производить какие-то непонятные и не очевидные действия на хосте и управляемой машине. Дальше вы поймете, что я имею ввиду. Но преодолев это препятствие, можно спокойно использовать виртуальную инфраструктуру, основанную на бесплатном гипервизоре от microsoft.

Основные сведения о виртуализации процессоров Hyper-V

Перед рассмотрением типов планировщиков гипервизора также полезно понимать архитектуру Hyper-V. Общую сводку можно найти в обзоре технологии Hyper-V. Ниже приведены важные понятия, связанные с этой статьей.

-

Hyper-V создает и управляет секциями виртуальных машин, в рамках которых ресурсы вычислений распределяются и совместно используются, под контролем гипервизора. Секции обеспечивают строгие границы изоляции между всеми гостевыми виртуальными машинами, а также между гостевыми и корневыми машинами.

-

Корневой раздел сам является разделом виртуальной машины, хотя у него есть уникальные свойства и более широкие привилегии, чем Гостевые виртуальные машины. Корневой раздел предоставляет службы управления, управляющие всеми гостевыми виртуальными машинами, обеспечивает поддержку виртуальных устройств для гостей и управляет всеми операциями ввода-вывода для гостевых виртуальных машин. Корпорация Майкрософт настоятельно рекомендует не выполнять никакие рабочие нагрузки приложений в корневом разделе.

-

Каждый виртуальный процессор (вице-президент) корневого раздела сопоставляется с 1:1 базовым логическим процессором (LP). Вице-президент узла всегда выполняется в одном базовом LP — миграция ВПС корневого раздела отсутствует.

-

По умолчанию LPs, на котором размещен ВПС, может также запускать гостевой ВПС.

-

Низкоуровневая виртуальная машина может быть запланирована для запуска на любом доступном логическом процессоре. В то время как планировщик низкоуровневой оболочки следит за локализацией временного кэша, топологией NUMA и многими другими факторами при планировании гостевого вице-президента, в конечном счете, его можно запланировать на любом сервере LP.

Настройка виртуальных коммутаторов

Перед тем, как мы приступим к установке виртуальных машин, подготовим для них сеть. Я не буду подробно рассказывать о нюансах работы сети в hyper-v. Это не тема текущего повествования. Просто создадим сетевой бридж для виртуальных машин. В оснастке управления выбираем справа «Диспетчер виртуальных коммутаторов», выбираем тип «Внешняя». Указываете имя коммутатора. Я рекомендую давать осмысленные названия, чтобы было проще потом управлять. Если это бридж в локальную сеть, то назовите виртуальный коммутатор local.

Сохраняйте настройки. Вы увидите предупреждение о том, что сетевые соединения будут сброшены. Все в порядке, соглашайтесь. Будет создан новый виртуальный сетевой интерфейс с теми же настройками, что были у физического. Но здесь есть один важный нюанс. Если ваш сервер получал сетевые настройки по dhcp, то он скорее всего получит новый ip адрес. Имейте это ввиду.

Основы работы с сетями Hyper-V

Основная сеть в Hyper-V довольно проста. В ней используются две части — виртуальный коммутатор и виртуальный сетевой адаптер. Для установки сети для виртуальной машины потребуется по крайней мере один из них. Виртуальный коммутатор подключается к любой сети на основе Ethernet. Виртуальный сетевой адаптер подключается к порту виртуального коммутатора, что позволяет виртуальной машине использовать сеть.

Самый простой способ установить базовую сеть — создать виртуальный коммутатор при установке Hyper-V. Затем при создании виртуальной машины ее можно подключить к коммутатору. При подключении к коммутатору на виртуальной машине автоматически добавляется виртуальный сетевой адаптер. Инструкции см. в статье Создание виртуального коммутатора для виртуальных машин Hyper-V.

Для обработки различных типов сетей можно добавить виртуальные коммутаторы и виртуальные сетевые адаптеры. Все коммутаторы являются частью узла Hyper-V, но каждый виртуальный сетевой адаптер принадлежит только одной виртуальной машине.

Виртуальный коммутатор — это программный коммутатор уровня 2 сети Ethernet на основе программы. Он предоставляет встроенные функции для мониторинга, управления и сегментирования трафика, а также для обеспечения безопасности и диагностики. Можно добавить в набор встроенных функций, установив подключаемые модули, также называемые расширениями. Они доступны из независимых поставщиков программного обеспечения. Дополнительные сведения о коммутаторе и расширениях см. в статье виртуальный коммутатор Hyper-V.

Параметры коммутатора и сетевого адаптера

Hyper-V предлагает три типа виртуальных коммутаторов и два типа виртуальных сетевых адаптера. Вы решите выбрать, какой из них вам нужен при создании. вы можете использовать диспетчер hyper-v или модуль hyper-v для Windows PowerShell создания виртуальных коммутаторов и виртуальных сетевых адаптеров и управления ими. Некоторые расширенные сетевые возможности, такие как расширенные списки управления доступом к портам (ACL), можно управлять только с помощью командлетов в модуле Hyper-V.

После создания виртуального коммутатора или виртуального сетевого адаптера можно внести некоторые изменения. Например, можно изменить существующий коммутатор на другой тип, но это повлияет на сетевые возможности всех виртуальных машин, подключенных к этому коммутатору. Таким образом, вы, вероятно, не будете делать этого, пока не поймете ошибку или не нужно проверять что-либо. В качестве другого примера можно подключить виртуальный сетевой адаптер к другому коммутатору, который вы можете сделать, если хотите подключиться к другой сети. Однако виртуальный сетевой адаптер нельзя изменить с одного типа на другой. Вместо изменения типа необходимо добавить другой виртуальный сетевой адаптер и выбрать соответствующий тип.

Типы виртуальных коммутаторов:

-

Внешний виртуальный коммутатор — подключается к проводных, физическим сетям путем привязки к физическому сетевому адаптеру.

-

Внутренний виртуальный коммутатор — подключается к сети, которая может использоваться только виртуальными машинами, работающими на узле с виртуальным коммутатором, а также между узлом и виртуальными машинами.

-

Частный виртуальный коммутатор — подключается к сети, которая может использоваться только виртуальными машинами, работающими на узле, на котором установлен виртуальный коммутатор, но не предоставляет сети между узлом и виртуальными машинами.

Типы виртуальных сетевых адаптеров:

Сетевой адаптер, относящийся к Hyper-V , доступен для виртуальных машин поколения 1 и 2. Он разработан специально для Hyper-V и требует наличия драйвера, который входит в службы интеграции Hyper-V. Этот тип сетевого адаптера быстрее и является рекомендуемым вариантом, если не требуется загрузка в сеть или не выполняется неподдерживаемая гостевая операционная система. Необходимый драйвер предоставляется только для поддерживаемых гостевых операционных систем

Обратите внимание, что в диспетчере Hyper-V и командлетах Networking этот тип просто называется сетевым адаптером.

Устаревший сетевой адаптер — доступен только в виртуальных машинах поколения 1. эмулирует адаптер PCI Fast Ethernet на основе Intel 21140 и может использоваться для загрузки в сеть, чтобы можно было установить операционную систему из службы, например Windows служб развертывания.

Изменение параметров виртуальной машины.

Сделаем небольшой обзор параметров виртуальной машины, чтобы вы могли посмотреть основные функции до того как примете решение пользоваться системой виртуализации Hyper-V.

Заходим в «Файл» — > «Параметры».(Рис.27)

Рис.27 — Заходим в «Файл» — > «Параметры»

Оборудование.

«Встроенное ПО» — можно изменить приоритет загрузки устройств в виртуальной машине.(Рис.28)

Рис.28 — Выбор приоритета загрузки.

«Безопасность» — можно «Включить/Выключить безопасную загрузку», «Включить/Выключить поддержку шифрования».(Рис.29)

Рис.29 — Параметры безопасности виртуально машины.

«Память» — можно отредактировать количество выделяемой ОЗУ, Включить/Выключить функцию Динамическая память.(Рис.30)

Рис.30 — Параметры оперативной памяти.

«Процессор» — можно отредактировать число виртуальных процессоров в соответствии с числом процессоров на физическом компьютере.(Рис.31)

Также можно распределить нагрузку в «Управление ресурсами».

Рис.31 — Параметры процессора.

«SCSI-контроллер» можно добавить Жёсткий диск, DVD-дисковод или Общий диск.(Рис.32)

Рис.32 — Параметры SCSI-контроллер.

Также можно изменить параметры подключенных носителей, к примеру здесь мы можем изменить вставленный в виртуальный DVD-дисковод ISO-образ.(Рис.33)

Рис.33 — Параметры носителей.

«Сетевой адаптер» можно изменить конфигурацию сетевого адаптера: Выбрать Виртуальный коммутатор, прописать VLAN ID, настроить Пропускную способность.(Рис.34)

Рис.34 — Параметры сети.

Управление.

«Имя» — можно легко поменять виртуальной машины, на более удобное для вашего пользования .(Рис.35)

Рис.35 — Смена имени.

«Службы интеграции» — Выбор служб которые вы хотите сделать доступными для виртуальной машины. .(Рис.36)

Рис.36 — Службы интеграции.

«Контрольные точки» — Здесь можно настроить Контрольные точки(snapshot, точки восстановления), включить автоматический режим их создания и назначить место их хранения.(Рис.37)

Рис.37 — Контрольные точки.

«Расположение файла Smart Padding» — Можно указать путь к файлу подкачки.(Рис.38)

Smart Padding — функция которая дает возможность при недостатке памяти для загрузки виртуальной машины использовать файл подкачки на хосте.

Рис.38 — Расположение файла Smart Padding.

«Автоматические действия при запуске» — Можно выбрать операцию, которую вы хотите выполнить с данной виртуальной машиной при запуске физического компьютера.(Рис.39)

Можно также назначить Задержку запуска.

Рис.39 — Автоматические действия при запуске.

«Автоматические действия при завершении» — Можно выбрать операцию, которую вы хотите выполнить с данной виртуальной машиной при завершении работы физического компьютера.(Рис.40)

Рис.40 — Автоматические действия при завершении.

У меня всё!

Поделиться публикацией

Была ли вам полезна статья? Есть возможность

поддержать проект.

Принцип работы вложенной виртуализации

Современные процессоры поддерживают аппаратные функции, которые делают виртуализацию быстрее и надежнее. Hyper-V использует эти расширения процессора (например, Intel VT-x и AMD-V) для выполнения виртуальных машин. Как правило, после запуска Hyper-V другое программное обеспечение блокируется с помощью этих возможностей процессора. Это предотвращает запуск Hyper-V на гостевых виртуальных машинах.

Вложенная виртуализация предоставляет поддержку этих аппаратных функций гостевым виртуальным машинам.

На схеме ниже показана роль Hyper-V без вложения. Низкоуровневая оболочка Hyper-V полностью контролирует возможности аппаратной виртуализации (оранжевая стрелка) и скрывает их от операционной системы.

На следующей схеме показана роль Hyper-V с включенной вложенной виртуализацией. В этом случае Hyper-V предоставляет расширения аппаратной виртуализации виртуальным машинам. Если вложение включено, гостевая виртуальная машина может установить собственную низкоуровневую оболочку и запускать свои гостевые виртуальные машины.

Настройка сети и Интернета для виртуальной машины

В качестве первого шага рекомендую настроить сеть для будущих виртуальных машин, при условии, что вы хотите иметь доступ в Интернет из установленных в них операционных систем. Это делается один раз.

Как это сделать:

- В диспетчере Hyper-V слева в списке выберите второй пункт (имя вашего компьютера).

- Кликните правой кнопкой мыши по нему (или пункт меню «Действие») — Диспетчер виртуальных коммутаторов.

- В диспетчере виртуальных коммутаторов выберите «Создать виртуальный сетевой коммутатор, «Внешняя» (если нужен Интернет) и нажмите кнопку «Создать».

- В следующем окне в большинстве случаев что-либо менять не нужно (если вы не специалист), разве что можете задать свое собственное имя сети и, если у вас есть и Wi-Fi адаптер и сетевая карта, выберите в пункте «Внешняя сеть» тот и сетевых адаптеров, который используется для доступа в Интернет.

- Нажмите Ок и дождитесь, когда будет создан и настроен виртуальный сетевой адаптер. В это время соединение с Интернетом может пропадать.

Готово, можно переходить к созданию виртуальной машины и установки Windows в нее (можно поставить и Linux, но по моим наблюдениям, в Hyper-V его производительность оставляет желать лучшего, рекомендую Virtual Box для этих целей).

Выбор оборудования

Рекомендации по оборудованию для серверов под управлением Hyper-V, как правило, похожи на те, которые являются невиртуализованными серверами, но серверы с Hyper-V могут демонстрировать увеличение загрузки ЦП, потребляют больше памяти и требуют большей пропускной способности ввода-вывода в связи с консолидацией серверов.

-

Процессоры

Hyper-V в Windows Server 2016 представляет логические процессоры как один или несколько виртуальных процессоров для каждой активной виртуальной машины. Hyper-V теперь требует процессоров, поддерживающих технологии преобразования адресов второго уровня (SLAT), такие как расширенные таблицы страниц (EPT) или таблицы вложенных страниц (НПТ).

-

Cache

Hyper-V может выиграть от больших кэшей процессора, особенно для нагрузок с большим рабочим набором в памяти и в конфигурациях виртуальных машин, в которых отношение виртуальных процессоров к логическим процессорам велико.

-

Память

Физическому серверу требуется достаточно памяти для корневого и дочернего разделов. Корневой разделу требуется память для эффективного выполнения операций ввода-вывода от имени виртуальных машин и операций, таких как моментальный снимок виртуальной машины. Hyper-V обеспечивает достаточный объем доступной памяти для корневого раздела и позволяет назначить оставшийся объем памяти дочерним секциям. Размеры дочерних секций должны быть в зависимости от потребностей ожидаемой нагрузки для каждой виртуальной машины.

-

Хранилище

Оборудование хранилища должно иметь достаточную пропускную способность ввода-вывода и емкость для удовлетворения текущих и будущих потребностей виртуальных машин, размещенных на физическом сервере. Эти требования следует учитывать при выборе контроллеров и дисков хранилища и выборе конфигурации RAID. Размещение виртуальных машин с ресурсоемкими рабочими нагрузками на разных физических дисках может повысить общую производительность. Например, если четыре виртуальные машины используют один диск и активно используют его, каждая виртуальная машина может выдавать только 25% пропускной способности этого диска.

Предварительные требования

Процессор Intel с технологиями VT-x и EPT.

- Узел Hyper-V должен работать под управлением Windows Server 2016/Windows 10 или более поздней версии.

- Версия конфигурации виртуальной машины 8.0 или более поздняя.

Процессор AMD EPYC/Ryzen или более новый.

- Узел Hyper-V должен работать под управлением Windows Server 2022/Windows 11 или более поздней версии.

- Версия конфигурации виртуальной машины 10.0 или более поздняя.

Примечание

В гостевой системе может использоваться любая поддерживаемая операционная система Windows на виртуальной машине. Более новые операционные системы Windows могут поддерживать компоненты паравиртуализации, повышающие производительность.

Как работает Hyper-V на VDS

VPS работает на базе технологии виртуализации и ничем не отличается от обычного сервера. На него точно так же можно установить любую систему. Разница состоит лишь в том, что версия серверная. Чаще всего люди выбирают ОС Windows и дистрибутивы Linux, такие как Debian, Ubuntu и CentOS.

Подобный вариант выбирают, когда ресурсов виртуального хостинга не хватает, а платить еще больше – не вариант. VDS с этой платформой выигрывает еще из-за высокого уровня безопасности размещаемых проектов.

Эта ВМ позволяют нескольким системам работать обособленно, не влиять друг на друга. Ограничения, конечно, есть, но они устанавливаются изначально, при выставлении подходящих параметров. И то эти значения можно увеличить или уменьшить в любой момент, просто поменяв конфигурацию на сайте хостинга.

Именно благодаря виртуальным машинам люди могут арендовать лишь часть сервера и отдавать при этом гораздо меньше денег.

1000 рублей в подарок на производительные VDS от Timeweb

Закажи VDS, пополни баланс на 1000 рублей, и мы добавим еще столько же. Активируй промокод community1000 в панели управления.

Заказать

Работа через PowerShell

Еще одно положительное качество гипервизора – эффективная работа и настройка VDS с помощью инструмента Windows PowerShell. Именно он позволяет автоматизировать множество задач, развернуть кластер Hyper-V Cluste с высокой отказоустойчивостью, а также многое другое. И при выполнении всех этих операций используется лишь командная строка, просто надо подобрать подходящий запрос для конкретного действия.

Максимум для виртуальных машин

Эти максимальные значения применяются к каждой виртуальной машине. Не все компоненты доступны в обеих поколениях виртуальных машин. Сравнение поколений см . в статье как создать виртуальную машину поколения 1 или 2 в Hyper-V?

| Компонент | Максимум | Примечания |

|---|---|---|

| Контрольные точки | 50 | Реальное количество может быть ниже в зависимости от доступного объема хранения. Каждая контрольная точка хранится в виде AVHD-файла, использующего физическое хранилище. |

| Память | 12 ТБ для поколения 2;1 ТБ для поколения 1 | Сверьтесь с требованиями для конкретной операционной системы, чтобы определить минимальный и рекомендуемый объемы. |

| Последовательные порты (COM) | 2 | Отсутствует. |

| Объем физических дисков, напрямую подключенных к виртуальной машине | Различается | Максимальный размер зависит от операционной системы на виртуальной машине. |

| Виртуальные адаптеры Fibre Channel | 4 | Мы рекомендуем подключать каждый виртуальный адаптер Fibre Channel к отдельной виртуальной сети SAN. |

| Виртуальные гибкие диски | 1 виртуальный гибкий диск. | Отсутствует. |

| Емкость виртуального жесткого диска | 64 ТБ для формата VHDX;2040 ГБ для формата VHD | Каждый виртуальный жесткий диск хранится на физическом носителе в виде файла .VHDX или .VHD в зависимости от используемого формата виртуального жесткого диска. |

| Виртуальные IDE-диски | 4 | Загрузочный диск (иногда называемый загрузочным диском) должен быть подключен к одному из устройств IDE. Диск запуска может быть виртуальным жестким диском или физическим диском, напрямую подключенным к виртуальной машине. |

| Виртуальные процессоры | 240 для поколения 2;64 для поколения 1;320 доступна для ОС узла (корневой раздел) | Число виртуальных процессоров, поддерживаемых операционной системой на виртуальной машине, может быть ниже. Дополнительные сведения см. в сведениях, опубликованных для конкретной операционной системы. |

| Виртуальные SCSI-контроллеры | 4 | Для использования виртуальных устройств SCSI требуются службы Integration Services, доступные для поддерживаемых гостевых операционных систем. дополнительные сведения о поддерживаемых операционных системах см. в разделе поддерживаемые виртуальные машины Linux и FreeBSD и поддерживаемые Windows гостевые операционные системы. |

| Виртуальные SCSI-диски | 256 | Каждый SCSI-контроллер поддерживает до 64 дисков; это означает, что в каждой виртуальной машине может быть настроено до 256 виртуальных SCSI-дисков (4 контроллера x 64 диска). |

| Виртуальные сетевые адаптеры | Windows Server 2019 и более поздних версий поддерживает 68:

Windows Server 2016 поддерживает 12:

|

Сетевой адаптер, относящийся к Hyper-V, обеспечивает лучшую производительность и требует наличия драйвера, входящего в службы Integration Services. дополнительные сведения см. в статье планирование сетей Hyper-V в Windows Server. |

Какие гостевые операционные системы поддерживаются?

Виртуальные машины поколения 1 поддерживают большинство гостевых операционных систем. виртуальные машины поколения 2 поддерживают большинство 64-разрядных версий Windows и более текущих версий операционных систем Linux и FreeBSD. Используйте следующие разделы, чтобы узнать, какое поколение виртуальной машины поддерживает операционную систему на виртуальной машине, которую вы хотите установить.

поддержка Windows гостевой операционной системы

в следующей таблице показано, какие 64-разрядные версии Windows можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| 64-разрядные версии Windows | Поколение 1 | 2-е поколение |

|---|---|---|

| Windows Server 2022 | ||

| Windows Server 2019 | ||

| Windows Server 2016 | ||

| Windows Server 2012 R2 | ||

| Windows Server 2012 | ||

| Windows Server 2008 R2 | ||

| Windows Server 2008 | ||

| Windows 11 | ||

| Windows 10 | ||

| Windows 8.1 | ||

| Windows 8 | ||

| Windows 7 |

в следующей таблице показано, какие 32-разрядные версии Windows можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| 32-разрядные версии Windows | Поколение 1 | 2-е поколение |

|---|---|---|

| Windows 10 | ||

| Windows 8.1 | ||

| Windows 8 | ||

| Windows 7 |

поддержка гостевых операционных систем CentOS и Red Hat Enterprise Linux

в следующей таблице показано, какие версии Red Hat Enterprise Linux (RHEL) и CentOS можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии операционной системы | Поколение 1 | 2-е поколение |

|---|---|---|

| Серия RHEL/CentOS 8. x | ||

| Серия RHEL/CentOS 7. x | ||

| Серия RHEL/CentOS 6. x | Примечание. поддерживается только в Windows Server 2016 и более поздних версиях. | |

| Серия RHEL/CentOS 5. x |

дополнительные сведения см. в статье CentOS and Red Hat Enterprise Linux virtual machines in Hyper-V.

Поддержка гостевой операционной системы Debian

В следующей таблице показано, какие версии Debian можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии операционной системы | Поколение 1 | 2-е поколение |

|---|---|---|

| Серия Debian 10. x (бустер) | ||

| Серия Debian 9. x (Stretch) | ||

| Серия Debian 8. x (Jessie) | ||

| Серия Debian 7. x (wheezy) |

Дополнительные сведения см. в статье Debian Virtual Machines on Hyper-V.

Поддержка гостевой операционной системы FreeBSD

В следующей таблице показано, какие версии FreeBSD можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии операционной системы | Поколение 1 | 2-е поколение |

|---|---|---|

| FreeBSD 12 – 12,1 | ||

| FreeBSD 11,1 – 11,3 | ||

| FreeBSD 11 | ||

| FreeBSD 10 – 10,3 | ||

| FreeBSD 9,1 и 9,3 | ||

| FreeBSD 8,4 |

Дополнительные сведения см. в статье виртуальные машины FreeBSD в Hyper-V.

Поддержка Oracle Linux гостевой операционной системы

В следующей таблице показаны версии серии ядра, совместимые с Red Hat, которые можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии серии ядра, совместимые с Red Hat | Поколение 1 | 2-е поколение |

|---|---|---|

| Серия Oracle Linux 8. x | ||

| Серия Oracle Linux 7. x | ||

| Серия Oracle Linux 6. x |

в следующей таблице показано, какие версии неповрежденных Enterprise ядра можно использовать в качестве операционной системы на виртуальной машине поколения 1 и 2.

| неповрежденные версии Enterprise ядра (UEK) | Поколение 1 | 2-е поколение |

|---|---|---|

| Oracle Linux UEK R3 QU3 | ||

| Oracle Linux UEK R3 QU2 | ||

| Oracle Linux UEK R3 QU1 |

Дополнительные сведения см. в статье Oracle Linux виртуальные машины в Hyper-V.

Поддержка гостевой операционной системы SUSE

В следующей таблице показано, какие версии SUSE можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии операционной системы | Поколение 1 | 2-е поколение |

|---|---|---|

| серия SUSE Linux Enterprise Server 15 | ||

| серия SUSE Linux Enterprise Server 12 | ||

| серия SUSE Linux Enterprise Server 11 | ||

| Open SUSE 12,3 |

Дополнительные сведения см. в статье о виртуальных машинах SUSE в Hyper-V.

Поддержка гостевой операционной системы Ubuntu

В следующей таблице показано, какие версии Ubuntu можно использовать в качестве гостевой операционной системы для виртуальных машин поколения 1 и 2.

| Версии операционной системы | Поколение 1 | 2-е поколение |

|---|---|---|

| Ubuntu 20.04 | ||

| Ubuntu 18.04 | ||

| Ubuntu 16.04 | ||

| Ubuntu 14.04 | ||

| Ubuntu 12.04 |

Дополнительные сведения см. в статье о виртуальных машинах Ubuntu в Hyper-V.

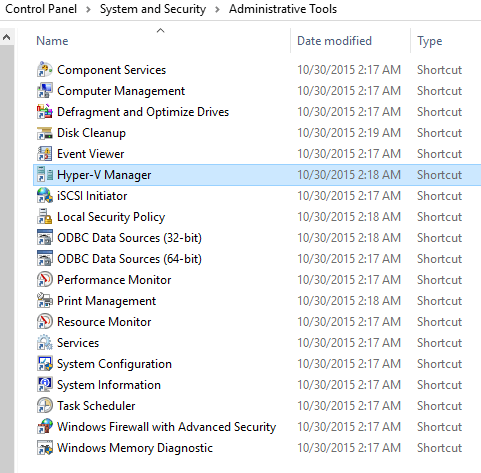

How to Download, Install, and Access Hyper-V Manager

Download and installation instructions for Hyper-V Manager are available in an earlier article in this series entitled “How to set up Hyper-V for Remote Management” under the section Using MMC Consoles to Manage Hyper-V.

Once you’ve got the tool installed, you’ll find it under the “Administrative Tools” menu selection on the Start Menu.

Tip: You must run Hyper-V Manager using an account that is in the Administrators group or Hyper-V Administrators group on the target system. Otherwise, you won’t even be able to connect to the Hyper-V host. If your management workstation’s administrator account does not have those capabilities, hold down while right-clicking the Hyper-V Manager shortcut, and then choose Run as different user:

You will then be prompted for the necessary credentials.

Рекомендации по схеме управления питанием

Виртуализация — это мощное средство, которое полезно при увеличении плотности рабочих нагрузок серверов, уменьшая количество необходимых физических серверов в центре обработки данных, повышая эксплуатационную эффективность и уменьшая затраты на энергопотребление. Управление питанием является критически важным для управления затратами.

В идеальной среде центра обработки данных потребление энергии управляется путем консолидации работы на компьютерах до тех пор, пока они не будут заняты, а затем отключены на бездействующие компьютеры. Если этот подход непрактичен, администраторы могут использовать схемы управления питанием на физических узлах, чтобы гарантировать, что они не потребляют больше энергии, чем необходимо.

Методы управления питанием сервера поставляются с учетом затрат, особенно в том случае, если рабочие нагрузки клиента не являются доверенными для диктовки политики физической инфраструктуры поставщика услуг размещения. Программное обеспечение уровня узла оставляет возможность максимально увеличить пропускную способность и свести к минимуму энергопотребление. В основном на бездействующих машинах это может привести к тому, что физическая инфраструктура завершится с помощью средней мощности, что приведет к тому, что отдельные рабочие нагрузки клиента будут работать медленнее, чем в противном случае.

Windows Server использует виртуализацию в самых разных сценариях. с легко загруженного сервера IIS на умеренную SQL Server в облачный узел с Hyper-V, на котором запущены сотни виртуальных машин на каждом сервере. Каждый из этих сценариев может иметь уникальные требования к оборудованию, программному обеспечению и производительности. по умолчанию сервер Windows использует и рекомендует сбалансированную схему управления питанием, которая позволяет экономить электроэнергию путем масштабирования производительности процессора на основе загрузки цп.

При использовании сбалансированной схемы управления питанием самые высокие состояния питания (и наименьшие задержки ответа в рабочих нагрузках клиента) применяются только в том случае, когда физический узел относительно занят. При значении детерминированного ответа с низкой задержкой для всех рабочих нагрузок клиента следует рассмотреть возможность переключения с сбалансированной схемы управления питанием на высокопроизводительную схему управления питанием. Высокопроизводительная схема управления питанием быстро запустит процессоры с максимальной скоростью, эффективно отключив Demand-Based переключение вместе с другими методами управления питанием и оптимизируя производительность по сравнению с энергосбережением.

Для клиентов, которым удовлетворена экономия затрат от сокращения числа физических серверов и требуется обеспечить максимальную производительность для виртуализованных рабочих нагрузок, следует рассмотреть возможность использования высокопроизводительной схемы управления питанием.